La startup china de inteligencia artificial DeepSeek acaba de lanzar oficialmente su último modelo de lenguaje grande (LLM), DeepSeek-V3-0324. Con una capacidad de hasta 641 GB, este modelo fue anunciado en la plataforma AI Hugging Face sin que se revelara mucha información, en línea con el estilo hermético sobre nuevos productos que la compañía siempre ha aplicado hasta ahora.

Lo especial de este modelo es la licencia MIT, que permite su uso libre para fines comerciales. Los resultados iniciales de referencia muestran que DeepSeek-V3-0324 es capaz de ejecutarse en configuraciones de hardware convencionales, como Mac Studio de Apple con el chip M3 Ultra. El científico de IA Awni Hannun informó que fue posible lograr velocidades de procesamiento de más de 20 tokens por segundo utilizando esta configuración. Esta capacidad de ejecutar un modelo de lenguaje grande en hardware básico en las instalaciones contrasta marcadamente con el enfoque tradicional de utilizar una infraestructura de centro de datos masiva para respaldar modelos de IA avanzados.

Según la información de DeepSeek, las pruebas iniciales han mostrado mejoras significativas con respecto a versiones anteriores. Este modelo ha sido probado rigurosamente por partes interesadas internas y ha demostrado un rendimiento excelente, superando incluso a todos los demás modelos de la competencia y superando al Claude Sonnet 3.5 de Anthropic en tareas que no requieren un pensamiento profundo. Sin embargo, a diferencia de los modelos estilo Sonnet que requieren una suscripción paga, DeepSeek-V3-0324 se puede descargar y usar completamente gratis.

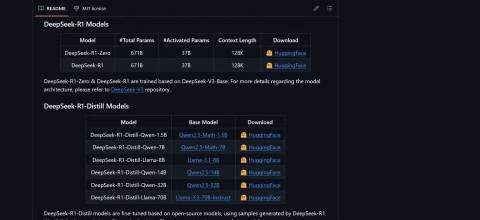

Técnicamente, DeepSeek-V3-0324 utiliza una arquitectura mixta de expertos (MoE). Se destaca por su capacidad de utilizar de forma selectiva alrededor de 37 mil millones de los 685 mil millones de parámetros por tarea, aumentando la eficiencia al reducir las demandas computacionales y manteniendo el rendimiento. Este modelo también aplica tecnologías de Atención Latente Multi-Cabeza (MLA) y Predicción Multi-Token (MTP), que contribuyen a mejorar la memoria de contexto y acelerar la salida.

Los usuarios pueden acceder a DeepSeek-V3-0324 a través de Hugging Face, la interfaz de chat y la API de OpenRouter, así como la plataforma de chat de DeepSeek si lo desean. El proveedor de servicios de inferencia Hyperbolic Labs también proporciona acceso al modelo.

Con el lanzamiento de DeepSeek-V3-0324, la compañía continúa afirmando su posición en la carrera por desarrollar modelos de lenguaje grandes, al tiempo que proporciona una opción poderosa y accesible para la comunidad de investigación y desarrollo de IA. La capacidad de ejecutarse en hardware comercial junto con una licencia gratuita seguramente abrirá muchas oportunidades de aplicación práctica para este modelo en el futuro cercano.