OpenAI ha presentado oficialmente tres nuevos modelos: GPT-4.1, GPT-4.1 mini y GPT-4.1 nano. Estos modelos vienen con capacidades de procesamiento de contexto masivo de hasta 1 millón de tokens y límites de conocimiento actualizados hasta junio de 2024.

La compañía dice que estos modelos superan a los recientemente actualizados GPT-4o y GPT-4o mini, que se lanzaron en julio pasado. Actualmente GPT-4.1 solo está disponible a través de API, por lo que aún no podrás usarlo directamente en ChatGPT.

OpenAI señala que GPT-4.1 solo estará disponible a través de API. En ChatGPT, se han integrado gradualmente muchas mejoras en el cumplimiento de instrucciones, la programación y la inteligencia en la última versión de GPT-4o, y la compañía continuará agregando más en futuras versiones.

Los puntos de referencia muestran las notables mejoras que aporta GPT-4.1. Este modelo obtiene un puntaje de 54.6% en SWE-bench Verified, un aumento de 21.4 puntos respecto de GPT-4o. El modelo obtuvo una puntuación del 38,3 % en MultiChallenge (un punto de referencia que mide el cumplimiento de las pautas) y estableció un nuevo récord de comprensión de videos de larga duración con una puntuación del 72,0 % en el punto de referencia Video-MME, donde los modelos analizan videos de hasta una hora de duración sin subtítulos.

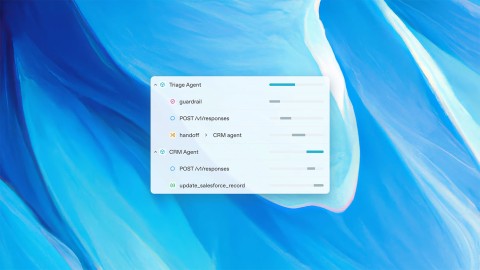

OpenAI también ha colaborado con socios alfa para probar el rendimiento de GPT-4.1 en casos de uso del mundo real.

- Thomson Reuters probó GPT-4.1 con su asistente legal de inteligencia artificial CoCounsel. En comparación con GPT-4o, GPT-4.1 registra un aumento del 17% en la precisión en la evaluación de múltiples documentos. Este tipo de trabajo depende en gran medida de la capacidad de rastrear el contexto en múltiples fuentes e identificar relaciones complejas, como términos conflictivos o dependencias ocultas, y GPT-4.1 ha demostrado constantemente un sólido desempeño.

- Carlyle utilizó GPT-4.1 para extraer datos financieros de documentos largos y complejos, incluidos archivos Excel y PDF. Según los puntos de referencia internos de la empresa, el modelo funciona un 50% mejor que los modelos anteriores en la recuperación de documentos. Es el primer modelo que maneja de manera confiable problemas como encontrar una "aguja en un pajar", perder información en medio de un documento y argumentos que requieren conectar información entre múltiples archivos.

El rendimiento es una cosa, pero la velocidad es igualmente importante. OpenAI dice que GPT-4.1 devuelve el primer token en aproximadamente 15 segundos cuando procesa 128.000 tokens, y hasta 30 segundos cuando procesa un millón de tokens. GPT-4.1 mini y nano son aún más rápidos.

GPT-4.1 nano normalmente responde en menos de 5 segundos a las indicaciones con 128.000 tokens de entrada. El almacenamiento en caché rápido puede reducir aún más la latencia y, al mismo tiempo, ahorrar costos.

La comprensión de imágenes también hizo avances significativos. En particular, GPT-4.1 mini supera a GPT-4o en varias pruebas comparativas visuales.

- En MMMU (incluidos gráficos, diagramas y mapas), GPT-4.1 mini obtuvo un puntaje de 73%. Esto es más alto que GPT-4.5 y supera ampliamente el 56% de GPT-4o mini.

- En MathVista (que prueba la capacidad de resolver problemas de imágenes), tanto GPT-4.1 como GPT-4.1 mini obtuvieron un puntaje de 57%, superando ampliamente el 37% de GPT-4o mini.

- En CharXiv-Reasoning , donde los modelos responden preguntas basadas en gráficos científicos, GPT-4.1 continúa liderando.

- En Video-MME (videos largos sin subtítulos), GPT-4.1 alcanzó el 72%, una mejora significativa respecto del 65% de GPT-4o.

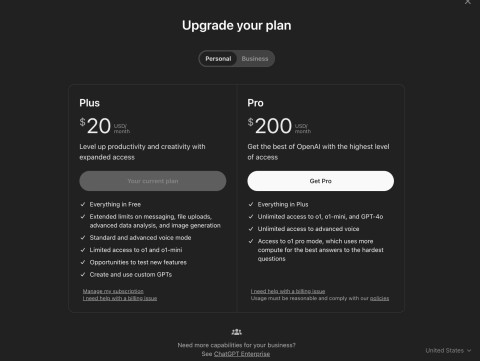

Sobre el precio:

- GPT-4.1 cuesta $2 por cada millón de tokens de entrada y $8 por cada millón de tokens de salida.

- GPT-4.1 mini tiene un precio de $0,40 para la entrada y $1,60 para la salida.

- El costo de entrada del nano GPT-4.1 es de $0.10 y el de salida de $0.40.

El uso del almacenamiento en caché de solicitudes o de la API por lotes puede reducir aún más estos costos, lo que resulta ideal para aplicaciones de gran escala. OpenAI también se está preparando para discontinuar el soporte para GPT-4.5 Preview el 14 de julio de 2025, citando el mejor rendimiento, la menor latencia y el menor costo de GPT-4.1.