OpenAI lanza GPT-4o, un gran modelo de lenguaje multimodal que admite conversaciones en tiempo real, preguntas y respuestas, generación de texto y más.

OpenAI es uno de los proveedores que dieron forma a la era de la IA generativa . La base del éxito y la popularidad de OpenAI es la familia GPT de modelos de lenguaje grandes (LLM) de la empresa , incluidos GPT-3 y GPT-4, junto con el servicio de inteligencia artificial conversacional ChatGPT de la empresa .

OpenAI anunció GPT-4 Omni (GPT-4o) como el nuevo modelo de lenguaje multimodal insignia de la compañía el 13 de mayo de 2024, durante el evento Spring Updates de la compañía. Como parte del evento, OpenAI publicó varios videos que demuestran las capacidades intuitivas de respuesta de voz y salida del modelo.

En julio de 2024, OpenAI lanzó una versión más pequeña de GPT-4o: GPT-4o mini . Este es el modelo pequeño más avanzado de la compañía.

¿Qué es GPT-4o?

GPT-4o es el modelo insignia en la cartera de tecnología LLM de OpenAI. O significa Omni y no es sólo una forma de publicidad exagerada, sino que se refiere a las múltiples modalidades del modelo para texto, imágenes y audio.

El modelo GPT-4o marca una nueva evolución del GPT-4 LLM que OpenAI lanzó por primera vez en marzo de 2023. Esta tampoco es la primera actualización de GPT-4, ya que el modelo se lanzó por primera vez en noviembre de 2023, con el lanzamiento de GPT-4 Turbo. El acrónimo GPT significa Transformador Generativo Pre-Entrenado. El modelo de transformador es un elemento fundamental de la IA generativa y proporciona una arquitectura de red neuronal capaz de comprender y generar nuevos resultados.

GPT-4o supera ampliamente lo que ofrece GPT-4 Turbo tanto en capacidades como en rendimiento. Al igual que su predecesor GPT-4, GPT-4o se puede utilizar para casos en los que se necesita generar texto, como resúmenes, preguntas y respuestas basadas en conocimientos. Este modelo también es capaz de razonar, resolver problemas complejos y programar.

El modelo GPT-4o introduce una nueva respuesta rápida a la entrada de audio que, según OpenAI, es similar a la de los humanos, con un tiempo de respuesta promedio de 320 milisegundos. El modelo también puede responder con una voz generada por IA que suena humana.

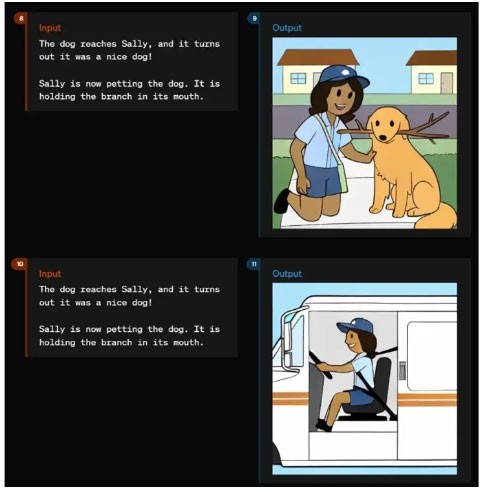

En lugar de tener modelos separados que entienden audio, imágenes (lo que OpenAI llama visión) y texto, GPT-4o combina esas modalidades en un solo modelo. Como tal, GPT-4o puede comprender cualquier combinación de entrada de texto, imagen y audio y responder con salida en cualquiera de esas formas.

La promesa de GPT-4o y sus capacidades de retroalimentación multimodal de audio de alta velocidad es permitir que el modelo participe en interacciones más naturales e intuitivas con los usuarios.

GPT-4o mini es el modelo más rápido de OpenAI y permite aplicaciones a un menor costo. GPT-4o mini es más inteligente que GPT-3.5 Turbo y un 60% más barato. Los datos de entrenamiento se ejecutan hasta octubre de 2023. GPT-4o mini está disponible en modelos de texto y visión para desarrolladores a través de la API de asistentes, la API de finalización de chat y la API de lotes. La versión mini también está disponible en ChatGPT, Free, Plus y Team para los usuarios.

¿Qué puede hacer GPT-4o?

En el momento de su lanzamiento, GPT-4o era el más capaz de todos los modelos OpenAI en términos de funcionalidad y rendimiento.

Muchas de las cosas que GPT-4o puede hacer incluyen:

- Interacción en tiempo real . El modelo GPT-4o puede entablar conversaciones verbales en tiempo real sin retrasos perceptibles.

- Preguntas y respuestas basadas en conocimientos . Al igual que todos los modelos GPT-4 anteriores, GPT-4o se entrenó utilizando una base de conocimientos y puede responder preguntas.

- Resumir y generar texto . Al igual que todos los modelos GPT-4 anteriores, GPT-4o puede realizar tareas LLM de texto comunes, incluida la generación y el resumen de texto.

- Razonamiento y generación multimodal . GPT-4o integra texto, voz e imágenes en un solo modelo, lo que permite el procesamiento y la respuesta combinados de tipos de datos. El modelo puede comprender audio, imágenes y texto a la misma velocidad. También puede generar retroalimentación a través de audio, imágenes y texto.

- Procesamiento del lenguaje y audio . GPT-4o tiene capacidades avanzadas para manejar más de 50 idiomas diferentes.

- Análisis de sentimientos . El modelo comprende el sentimiento del usuario en diferentes modalidades de texto, audio y video.

- Tono de voz . GPT-4o puede generar voces con matices emocionales. Esto lo hace eficaz para aplicaciones que requieren una comunicación sensible y matizada.

- Análisis de contenido de audio . El modelo puede generar y comprender el lenguaje hablado, lo que puede aplicarse en sistemas activados por voz, análisis de contenido de audio y narración interactiva.

- Traducción en tiempo real. Las capacidades multimodales de GPT-4o pueden admitir la traducción en tiempo real de un idioma a otro.

- Comprender imágenes y vídeos. El modelo puede analizar imágenes y videos, lo que permite a los usuarios cargar contenido visual que GPT-4o puede comprender, interpretar y proporcionar análisis.

- Análisis de datos . Las capacidades de razonamiento y visión pueden permitir a los usuarios analizar datos contenidos en gráficos de datos. GPT-4o también puede generar gráficos de datos basados en análisis o indicaciones.

- Subir archivo. Además de los umbrales de conocimiento, GPT-4o admite la carga de archivos, lo que permite a los usuarios proporcionar datos específicos para su análisis.

- Conciencia contextual y memoria. GPT-4o puede recordar interacciones previas y mantener el contexto en conversaciones largas

- Ventana de contexto grande . Con una ventana de contexto que admite hasta 128 000 tokens, GPT-4o puede mantener la coherencia en conversaciones o documentos largos, lo que lo hace adecuado para análisis detallado.

- Reducir las alucinaciones y mejorar la seguridad . El modelo está diseñado para minimizar la creación de información inexacta o engañosa. GPT-4o incluye protocolos de seguridad avanzados para garantizar una salida consistente y segura para los usuarios.

Cómo utilizar GPT-4o

Hay varias formas en que los usuarios y las organizaciones pueden utilizar GPT-4o.

- ChatGPT es gratuito. El modelo GPT-4o estará disponible de forma gratuita para los usuarios del chatbot ChatGPT de OpenAI. Cuando esté disponible, GPT-4o reemplazará el valor predeterminado actual para los usuarios de ChatGPT Free. Los usuarios de ChatGPT Free tendrán acceso limitado a los mensajes y no tendrán acceso a algunas funciones avanzadas, incluida la carga de archivos y el análisis de datos.

- ChatGPT Plus . Los usuarios del servicio pago de OpenAI para ChatGPT obtendrán acceso completo a GPT-4o, sin las limitaciones de funciones disponibles para los usuarios gratuitos.

- Acceso API . Los desarrolladores pueden acceder a GPT-4o a través de la API de OpenAI. Esto permite la integración en aplicaciones para aprovechar al máximo las capacidades de GPT-4o para las tareas.

- Aplicación de escritorio. OpenAI ha integrado GPT-4o en aplicaciones de escritorio, incluida una nueva aplicación para macOS de Apple que también se lanzó el 13 de mayo.

- GPT personalizado. Las organizaciones pueden crear versiones GPT personalizadas de GPT-4o para adaptarse a necesidades comerciales o departamentales específicas. Es probable que los modelos personalizados estén disponibles para los usuarios a través de la tienda GPT de OpenAI.

- Servicios Microsoft OpenAI. Los usuarios pueden explorar las capacidades de GPT-4o en modo de vista previa en Microsoft Azure OpenAI Studio, que está diseñado específicamente para manejar entradas multimodales, incluido texto y visión. Esta versión inicial permite a los clientes de Azure OpenAI Service experimentar con las capacidades de GPT-4o en un entorno controlado, con planes de expandir sus capacidades en el futuro.

Además, los lectores pueden consultar: Diferencias entre GPT-4, GPT-4 Turbo y GPT-4o .